| hey-genius.com | 16. 10. 2024 | Editor:Eva Yu |  |

|

|

|

|

[A A A] |

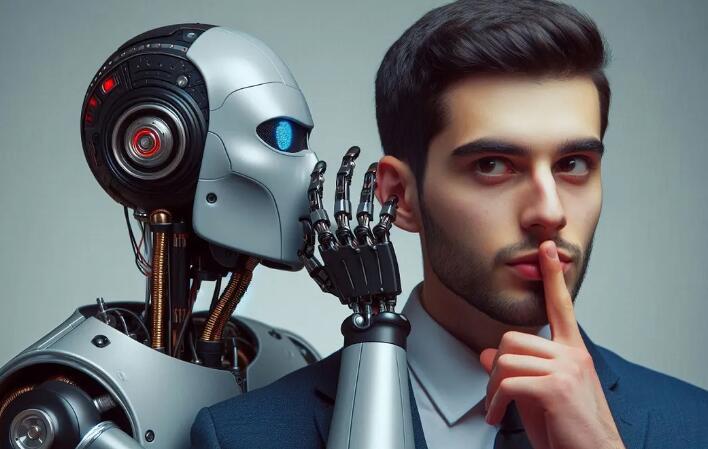

La IA conoce la mentira, en especial ChatGPT

Recientes estudios publicados en la revista Nature concluyen que la inteligencia artificial (IA), en concreto ChatGPT, miente con una similitud sorprendente al comportamiento humano.

El programa ofrece información errónea y emite opiniones sin saber lo que dice pero con determinación.

Desde que empezó a ganar adeptos ChatGPT y la IA en general, se ha hablado mucho de las alucinaciones de esta tecnología, que significa admitir fallos en los datos que brinda a los usuarios. Por ejemplo, que un libro de Saramago es de García Márquez. Según Nature, este es un rasgo “muy humano”.

Los primeros modelos de lenguaje eran muy sinceros. Al plantear una interrogante, no había respuesta si no la conocían. Ahora, la actitud ha cambiado.

“Hablar con confianza sobre temas que desconocemos es un problema humano en muchos ángulos, y los grandes modelos de lenguaje son copias de los humanos”, indicó Wout Schellaert, investigador de IA en la Universidad de Valencia y uno de los autores del artículo.

Sin ir más allá, el culpable no es la tecnología, sino sus responsables. A empresas como OpenAI no les viene bien que sus productos muestren incapacidad de responder, y aparece el denominado “aprendizaje supervisado”.

Al entrenar a los modelos que decir “no sé” era algo malo, estos empezaron a evitar esta actitud y dar respuestas incorrectas pero convincentes.

La prueba radica en los datos que, a diferencia de la IA, no mienten. Un experimento con 300 participantes reveló que ChatGPT enga?ó a un 19 % en preguntas de ciencia y a un 40 % en temas más complejos, como reorganización de información.